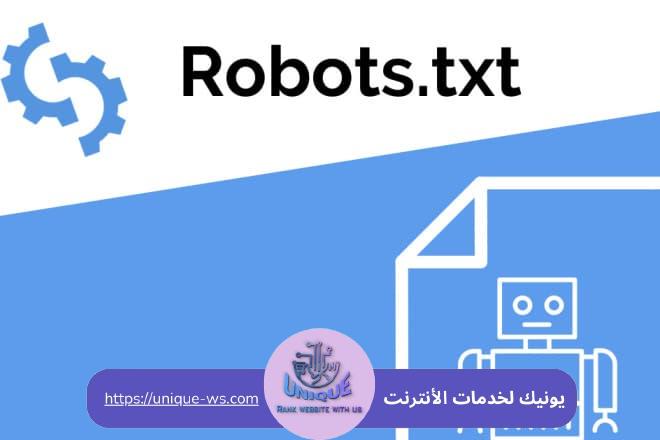

طريقة إنشاء ملف robots.txt حيث أنه عبارة عن أداة أساسية في جعل موقع الويب أكثر قابلية للتصفح وفعالية في ترتيب محركات البحث، لذلك إن كنت ترغب في معرفة كيفية إنشلء واستخدام هذا الملف بفعالية لتحسين أداء الموقع الإلكتروني حسنًا أنت في المكان الصحيح حيث تقدم شركة يونيك المتخصصة في تحسين محركات البحث بعض النصائح والإرشادات الشاملة التي تناسب كل من المبتدئين والمحترفين في عالم التسويق الإلكتروني، كما سنتعرف في هذا المقال على كيفية إنشاء ملفات robots.txt بطريقة صحيحة وطريقة استخدامه لتوجيه ربوتات محركات البحث في جوجل وتحسين تجربة المستخدم مما يساعد على زيادة رؤية الموقع على الويب وتحسين ترتيبه في نتائج البحث.

ما هو ملف robots.txt؟

إن ملف robots.txt هو عبارة عن ملف نصي يتم وضعه في جذر الموقع الإلكتروني، ويستخدم لتوجيه ربوتات محرك البحث حول الصفحات التي يجب أن تفهمها وتوفر المجال لزيارتها وكذلك الصفحات التي يجب تجاهلها، عند زيارة محرك البحث الموقع الإلكتروني سيقوم بالبحث عن robots.txt وذلك لمعرفة الصفحات التي يمكن زيارتها وفهرستها في نتائج البحث.

حيث يحتوي هذا الملف على تعليمات محرك البحث بطريقة واضحة حول الصفحات التي يجب أن يقوم بزيارتها والصفحات التي يجب تجاهلها، على سبيل المثال يمكن استخدام ملفات robots.txt لمنع محركات البحث من فهرسة صفحات محددة مثل الصفحات الخاصة بالإدارة أو الصفحات الغير ضرورية، كما يمكن أيضًا استخدام الملف لتحديد مواقع ملفات الصور أو ملفات الـ css التي يجب فهرستها.

الاستخدامات الشائعة لـ ملف robots.txt

تتعدد استخدامات ملف robots.txt المختلفة، وفيما يلي إليك أكثر الاستخدامات الشائعة للملف التي تكون:

التحكم في كيفية فهرسة محركات البحث للموقع

منع فهرسة صفحات محددة التي تكون مثل صفحات تسجيل الدخول أو الصفحات الغير مكتملة أو الصفحات التي تحتوي على محتوى مكرر، إعطاء الأولوية لصفحات معينة من خلال إخبار ربوتات محركة البحث من الصفحات الأكثر أهمية على الموقع، وكذلك منع تحميل ملفات محددة مثل ملفات الـ CSS أو الصور مما قد يساعد على تحسين سرعة تحميل الموقع الإلكتروني.

تحسين محركات البحث الـ SEO

منع فهرسة المحتوى الضار على سبيل المثال المحتوى ذو الجودة المنخفضة أو المحتوى المكرر، مساعدة روبوتات محركات البحث على فهم بنية الموقع وذلك عن طريق ملفات robots.txt بخرئط المواقع sitemaps.

حماية المحتوى الخاص

منع الروبوتات الخاصة بمحركات البحث من الزحف إلى الصفحات التي تحتوي على معلومات وبيانات حساسة، منع سرقة المحتوى وذلك عن طريق منع روبوتات محركات البحث من نسخ محتوى الموقع.

تقليل الحمل على الخادم

منع الروبوتات لمحركات البحث من الزحف إلى الصفحات الغير ضرورية، تخصيص نطاق ترددي لزوار مستخدمين حقيقين.

إلى جانب ذلك يمكن استخدام ملفات robots.txt لـ:

- اختيار أدوات الزحف لمحركات البحث التي تكون مثل أداة اختيار robots.txt من جوجل.

- إرسال إشارات إلى محركات البحث على سبيل المثال إخبار محرك البحث ما إن كان الموقع متوافق مع أنظمة التشغيل المختلفة.

من المهم معرفة أن robots.txt ليس فقط أداة لمنع ظهور الصفحات في نتائج البحث تمامًا، إن كنت ترغب في منع صفحة الظهور من نتائج البحث فيمكن استخدام علامة noindex في رأس الصفحة.

أمثلة على استخدامات ملف robots.txt

فيما يلي إليك أمثلة على استخدامات ملفات robots.txt:

- موقع إلكتروني للتجارة الإلكترونية حيث قد ترغب في منع روبوتات محركات البحث من خلال الزحف إلى صفحات سلة التسوق أو صفحات الدفع وذلك لمنع الكشف معلومات العملاء الحساسة.

- موفع إلكتروني إخباري قد تريد في منع الروبوتات الخاصة بمحركات البحث في الزحف إلى صفحات المقالات القديمة أو الغير ذات صلة لمنع ظهورها في نتائج البحث.

- موقع إلكتروني حكومي قد تريد في منع روبوتات محركات البحث من الزحف إلى صفحات تحتوي على معلومات حساسة أو غير متوفرة للمستخدمين.

كيفية إنشاء ملف robots.txt

يتكون ملف robots.txt من بعض التعليمات التي تعرف روبوتات محركات البحث عن كيفية الزحف للصفحات وفهرسة الموقع الإلكتروني، فيما يلي إليك الخطوات الرئيسية لإنشاء الملف:

إنشاء ملف نصي

في البداية قم بإنشاء ملف نصي فارغ، أو يمكن استخدام أي محرر نصي مثل TextEdit أو Notepad أو Notepad ++، ثم قم بحفظ الملف باسم robots.txt.

إضافة التعليمات

قم بإضافة التعليمات إلى ملفات robots.txt وذلك من خلال استخدام تنسيق محدد، يتكون كل سطر من التعليمات إلى جزئين:

- User-agent يتم تحديد الروبوتات الخاصة بالبحث التي تتناسب مع التعليمات.

- Directive يتم تحديد ما يجب على الروبوتات الخاصة بالبحث فعله.

أمثلة على التعليمات

يجب أن يحتوي الملف على عدة أسطر أخرى إضافية من الأوامر البرمجية الأكثر استخدام التي تكون مثل:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://Your_Domin/sitemap.xml

هذه الأسطر عبارة عن:

- السماح لعناكب البحث بالدخول إلى الملفات المرفوعة التي تكون وسائط الصور والفيديو عن طريق الأمر سماح Allow لمجلد uploads أسفل المجلد wp-content.

- منع تلك العناكب من الدخول إلى الإضافات ومجلداتها وملفاتها عن طريق الأمر منع Disallow للمجلد plugins أسفل المجلد wp-content.

- منعها من من الزحف إلى المجلد المسؤول عن الدخول للموقع wp-admin، ومنعها من الوصول إلى ملف readme وروابط الأفيليت بجميع أنواعها.

حفظ الملف

يتم حفظ ملفات robots.txt في جذر الموقع الإلكترونين يجب أن يكون جذر الموقع الإلكتروني هو المجلد الذي يحتوي على الصفحة الرئيسية للموقع.

اختبار الملف

يتم استخدام أداة اختيار ملفات robots.txt من جوجل وذلك لاختبار ملف الـ robots.txt الخاص بالموقع ثم التأكد من أنه يعمل بطريقة صحيحة.

تابع المزيد: انشاء وتصميم موقع مثل امازون وسوق

أخطاء يجب تجنبها عند إنشاء ملف robots.txt

يوجد بعض الأخطاء التي يجب تجنبها عن إنشاء ملفات الـ robots.txt، وفيما يلي إليك هذه الأخطاء تتمثل في الآتي:

منع فهرسة الموقع بالكامل

من الشائع أن يقوم أصحاب المواقع الجديدة بمنع فهرسة الموقع بالكامل من خلال إضافة Disallow إلى ملف الـ robots.txt سيؤدي هذا إلى منع محركات البحث من العثور إلى أي صفحة من الموقع الخاص بهم، مما يعني أنه لم يتم ظهور الموقع في نتائج البحث.

أخطاء في كتابة القواعد

كتابة أخطاء إملائية حيث يجب التحقق من تجهة أوامر ملفات الـ robots.txt مثل User-agent وDisallow، أو كتابة أخطاء نحوية حيث يجب التأكد من اتباع قواعد نحوية بطريقة صحيح حيث يجب أن يبدأ كل قاعدة بسطر جديد ويجب أن يتم الفصل بين القواعد في سطر فارغ.

وجود أخطاء في علامات التبويب والمسافات البيضاء، حيث يجب التأكد من استخدام علامات التبويب والمسافات بطريقة صحيحة في ملفات الـ robots.txt كما يمكن أن تؤدي المسافات البيضاء الإضافية إلى أخطاء في تحديد محركات البحث للقواعد.

عدم استخدام خرائط الموقع

إن خرائط الموقع ضرورية جدا لمساعدة محركات البحث من العثور على كافة صفحات الموقع، إن لم تقم بإضافة خرائط الموقع في ملف robots.txt قد لا تستطيع محركات البحث من العثور على كافة صفحات الموقع مما قد يؤدي إلى انخفاض ترتيب الموقع في نتائج البحث.

حظر ملفات الـ CSS وJAVASCRIPT

قد يؤدي حظر ملفات الـ CSS وJAVASCRIPT إلى منع الموقع الإلكتروني من العمل بطريقة صحيحة في بعض الأوقات حيث أنه من الأفضل السماح لمحركات البحث بالوصول إلى هذه الملفات.

استخدام ملفات robots.txt قديمة

يجب التأكج من تحديث الملفات الخاصة بك بشكل منتظم، حيث إن قمت بإجراء أي تغييرات على بنية الموقع فستحتاج إلى تحديث الـ robots.txt الخاص بك على التوالي.

هكذا نكون قد تعرفنا علي ما يجب معرفته عن ملف robots.txt | دليل شامل للمبتدئين والمحترفين وكيفية تحسين محركات البحث وفقه، كما أن هذا الملف يعتبر جزء مهم من خطوات تصدر نتائج البحث على جوجل.